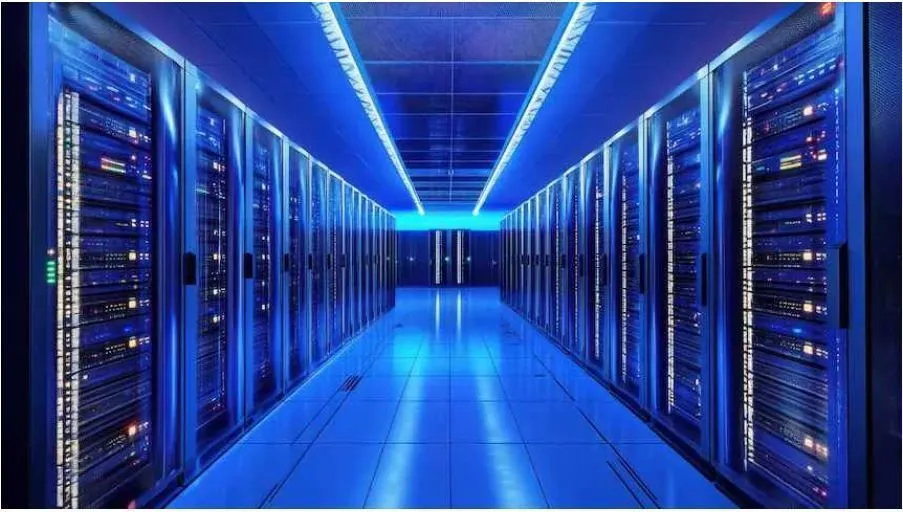

Data centers são a espinha dorsal invisível da nova economia. Quando falamos em inteligência artificial, costumamos focar nos algoritmos, na capacidade de predição, no impacto sobre o mercado de trabalho. Mas pouco se fala sobre o corpo físico que sustenta essa inteligência: estruturas que consomem energia, armazenam dados sensíveis e concentram poder informacional em uma escala que desafia a lógica jurídica tradicional. É exatamente nesse ponto que o Projeto de Lei 3018/2024 tenta intervir: propondo um marco regulatório para os data centers de IA, com foco em segurança, privacidade, transparência e sustentabilidade. À primeira vista, parece uma resposta racional e bem-intencionada ao avanço tecnológico. Mas, sob a ótica da Análise Econômica do Direito, o que está em jogo é muito mais do que técnica — é a disputa pela modelagem dos incentivos que moldarão o futuro da inovação digital.

O primeiro aspecto relevante do PL está na tentativa de corrigir uma falha de mercado clara: a assimetria entre os custos sociais decorrentes da má governança de dados e os benefícios privados auferidos pelos operadores. Quando dados pessoais são vazados, manipulados ou utilizados para treinar algoritmos enviesados, quem paga a conta não é, via de regra, o operador do data center — é a sociedade, é o cidadão cuja autonomia foi afetada sem sequer perceber. Como alerta Steven Shavell, o Direito se justifica economicamente quando cria mecanismos para internalizar externalidades negativas. É isso que o artigo 3º do projeto tenta fazer ao exigir segurança cibernética robusta, rastreabilidade algorítmica e transparência sobre o uso de dados. A regulação impõe um custo que obriga o agente privado a considerar os efeitos colaterais de sua atuação — e esse é o coração de toda regulação eficiente: fazer com que quem lucra com o risco também arque com seus custos.

No entanto, a imposição de transparência algorítmica traz consigo um dilema técnico e econômico relevante. Ao exigir que o operador divulgue informações sobre o funcionamento de algoritmos de IA, a norma toca em um dos pontos mais sensíveis da atualidade: a opacidade dos modelos baseados em redes neurais profundas. Nem sempre é possível explicar de forma inteligível como um sistema chegou àquela conclusão, e, quando é, isso pode exigir a exposição de segredos comerciais valiosos. A exigência genérica de transparência, sem a mediação de mecanismos técnicos adequados, pode desencorajar investimentos ou gerar apenas uma aparência de conformidade, com relatórios padronizados e ineficazes. A AED alerta para esse risco: normas que tentam resolver tudo por comando direto, sem considerar os custos de cumprimento, podem ser economicamente ineficientes, criando incentivos à evasão, à litigiosidade ou à simples paralisia decisória.

Outro ponto sensível é a eficiência energética. A imagem de que a IA é uma solução “limpa”, que flutua na nuvem, contrasta com a realidade concreta dos data centers: estruturas que demandam energia em volumes colossais, especialmente durante o treinamento de grandes modelos de linguagem. O artigo 5º do projeto acerta ao incluir exigências claras de eficiência energética e sustentabilidade ambiental, mas o desafio aqui é mais estrutural: mesmo quando os equipamentos se tornam mais eficientes, o efeito rebote pode anular esses ganhos, já que a maior eficiência reduz o custo marginal do processamento e estimula o uso excessivo. A resposta da AED seria a criação de mecanismos dinâmicos de preços e incentivos — como a tributação progressiva com base na intensidade energética por terabyte processado, ou subsídios apenas para data centers alimentados por fontes renováveis. Sem isso, o que temos é um comando normativo bem-intencionado, mas ineficaz diante da lógica econômica de maximização privada.

A exigência de governança clara de dados, com designação de Encarregado de Proteção e realização periódica de relatórios de impacto, está alinhada com o que Richard Posner chamaria de “precificação do risco informacional”. Ao exigir que as empresas revelem e internalizem o custo da coleta e tratamento de dados, o Estado obriga os operadores a lidarem com o dilema da confiança, que é o bem mais escasso da era digital. No entanto, o simples cumprimento formal da norma não garante sua eficácia. Como demonstro em meu livro, normas só geram efeitos reais quando combinadas com estruturas reputacionais e incentivos compatíveis. Por isso, a regulação de data centers deve ser acompanhada de mecanismos reputacionais, como rankings públicos, certificações de boas práticas e obrigações de divulgação que impactem diretamente a decisão de investidores e consumidores.

Em resumo, o PL 3018/2024 tem méritos importantes e deve ser compreendido como o primeiro passo na construção de uma arquitetura institucional para os data centers de IA. Mas se quisermos que essa arquitetura seja funcional, ela precisa ser pensada como um sistema de incentivos. Não basta impor obrigações; é preciso modelar comportamentos. Isso exige diálogo com os agentes do setor, análise econômica rigorosa e a coragem de experimentar formatos regulatórios dinâmicos. Como ensinou Guido Calabresi, o bom Direito não é aquele que proíbe tudo, mas o que oferece caminhos para que o interesse privado seja compatível com o bem público. A inteligência artificial vai redefinir mercados, democracias e relações humanas. Se quisermos que essa redefinição seja ética, segura e eficiente, precisamos começar por onde tudo começa: a infraestrutura. Regular data centers é regular o futuro.